时间:2024-07-07|浏览:275

谷歌的DeepMind研究团队宣布了一种全新的人工智能(AI)训练方法,显著减少了所需的计算资源和时间。这一突破性技术不仅能加速AI开发,还能降低成本,对环境保护也大有裨益。

在最近发表的研究论文中,研究人员介绍了一种名为“跨模式对比学习与联合示例选择(JEST)”的新方法。研究表明,这种方法比现有最先进的模型效率高出许多,迭代次数减少了13倍,计算量降低了10倍。

AI行业以其高能耗闻名。像ChatGPT这样的大型AI系统需要大量计算能力,这不仅耗电,还需要大量水资源来冷却系统。例如,微软的水消耗量因AI计算需求的增加,从2021年到2022年增长了34%。据报道,ChatGPT每5至50次查询就会消耗近半升水。

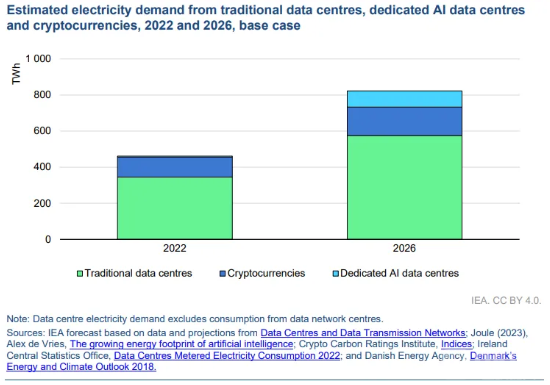

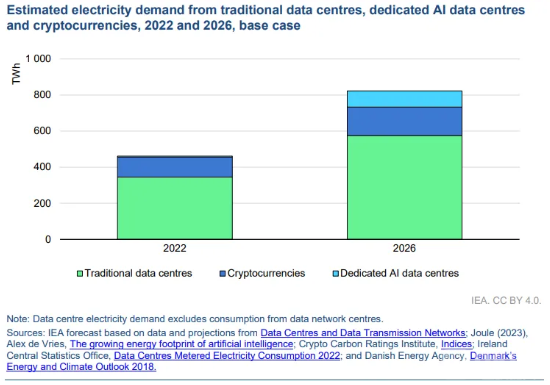

国际能源署(IEA)预测,数据中心的电力消耗将在2022年至2026年间翻一番,这种增长与被批评为高能耗的加密货币采矿相似。

JEST方法有望成为解决这一问题的关键。谷歌表示,通过优化AI训练中的数据选择,JEST可以显著减少迭代次数和所需计算能力,从而降低总能耗。这种方法旨在提高AI技术的效率,并减少其对环境的影响。

如果JEST技术在大规模应用中被证明有效,AI训练者将只需一小部分资源即可训练他们的模型。这意味着他们可以利用现有资源开发更强大的AI工具,或在开发新模型时消耗更少的资源。

JEST通过选择互补批次的数据来最大化AI模型的学习能力,而不是像传统方法那样选择单个示例。该算法考虑了数据群体的整体构成,从而提高了训练效率。

例如,学习多种语言时,将汉语,韩语和日语一起学习,而不是单独学习,可以利用它们之间的相似性加速学习进程。谷歌采用了类似的方法,并取得了成功。

研究指出,选择共同批次的数据比选择独立的示例更有效。JEST过程识别数据点之间的依赖关系,提高了AI训练的速度和效率,同时需要更少的计算能力。

谷歌研究人员使用“多模式对比学习”来指导数据选择过程,使模型能够专注于高质量,精心策划的数据集,进一步优化训练效率。

研究表明,多个基准测试的性能都有显著提高。例如,使用JEST对常见的WebLI数据集进行训练显示出学习速度和资源效率的显著提升。

研究人员还发现,该算法能快速识别具有高学习潜力的数据子集,通过关注特定数据来加快训练过程。这种“数据质量引导”技术强调质量而非数量,适用于AI训练。

研究指出,在小型精心策划的数据集上训练的参考模型可以有效指导更大数据集的策划,从而在许多任务上训练出优于参考模型的高质量模型。